在AI浪潮的每一个关键节点,总能看到贾扬清的身影,却鲜有人听过他的声音。从小时候就是“理工神童”,一路进入清华,再赴伯克利攻读博士,他的每一步都走在时代技术变革的前线。

他在博士阶段写出Caffe,让深度学习第一次具备了“跑进产品”的工程能力;在Facebook推动Caffe2与ONNX,把模型训练和部署打通;回国加入阿里云后,他搭建大模型底层平台,让“云上AI”真正可用可控。而当行业开始追逐模型和流量,他却再次转身,创办Lepton AI,把注意力投向最被忽视的“部署难题”。

2025年,英伟达收购Lepton AI,这场静悄悄的并购再次验证了他的判断力。贾扬清没有高调演讲、没有流量包装,他用三次系统级工程落地告诉世界:真正改变时代的,不是台上的风口,而是台下那根根牢固的地基。

少年起步:他为什么不做科学家,而是成了工程师

在那个还没被STEM概念统治的年代,贾扬清已经展现出理工少年的典型特质:逻辑敏锐、沉得住气,也憋得住劲。

3岁识字,5岁痴迷《安徒生童话》,小学时转学至绍兴市最好的学校之一,成绩始终名列前茅。

初二那年,学习计算机开始流行。贾扬清的父母花7000元为他购入一台奔腾Ⅱ电脑,这在当时不啻为一笔巨款。第一次看到同学用鼠标点击图形界面操作,他便回家尝试用BASIC语言写出人生第一个小程序:在输入出生年份后,屏幕显示对应的生肖。彼时的他并不知道,这种“屏幕动起来”的愉悦感,会在多年后变成构建AI系统平台的那份坚实底色。

贾扬清痴迷于“让计算机动起来”的一切,自学装软件、调系统、玩雷神游戏,也尝试破解它们的运行机制。比起纸面上的理论推导,他更享受代码运行时的即时反馈,更愿意钻进机房而不是图书馆。这是他选择工程的第一步——不是出于回避理论,而是出于对“可运行系统”的天然执着。

“计算机让我觉得,可以创造出一个新的世界。”他后来说。

他并非没有文学梦。初中语文课上,老师让同学们写《论〈西厢记〉里的诗歌和艺术》,他认真写了满页,引来老师感叹“太早熟了”。他从父亲的书架中翻出《西方文学史》《十四行诗》,反复揣摩其中句意,甚至一度“偏文科”得让家人担心。但最终,他还是选了理科。他后来这样总结当年的选择:“文科靠感悟,理科可以靠自己的努力,走得更远。”

到了高中,他的“理工能力”已不再是爱好,而是成绩的证明。他在物理、数学竞赛中频频获奖,拿下全国奖项,成为省重点中学“备战清北”的重点苗子。2002年,他考入清华大学自动化系,成为清北“学霸”输送链条上的一环。

贾扬清在本科期间,成绩名列前茅,经常在图书馆开门前排队自习。他在大三选修了张长水教授的《模式识别和智能系统》课程,一次图像识别实验激发了他对人工智能的浓厚兴趣。那时,人工智能在国内高校还远未成热,神经网络也处于学术低潮期,但他已主动查阅Hinton等人的论文,自学玻尔兹曼机等理论,并坚持课余阅读相关资料,尝试理解背后的数学与系统逻辑。毕业前,他参与交通图像识别项目,在四环桥下拍摄车流照片、手工标注图像、调试算法,探索用经典计算机视觉方法解决现实问题。

2006年,他以优秀毕业生身份免试直升本校硕士研究生,继续攻读“模式识别与智能系统”方向。对多数人来说,那时AI还只是未来;对他来说,AI已写进每日的计划清单,和数学、代码、工具链一样,是现实且具体的目标。在许多人尚未意识到人工智能潜力的年代,他已悄然迈入这条道路。

当他拿到博士offer时,他没有犹豫。他要去的,不是更深的象牙塔,而是更广的“代码世界”。

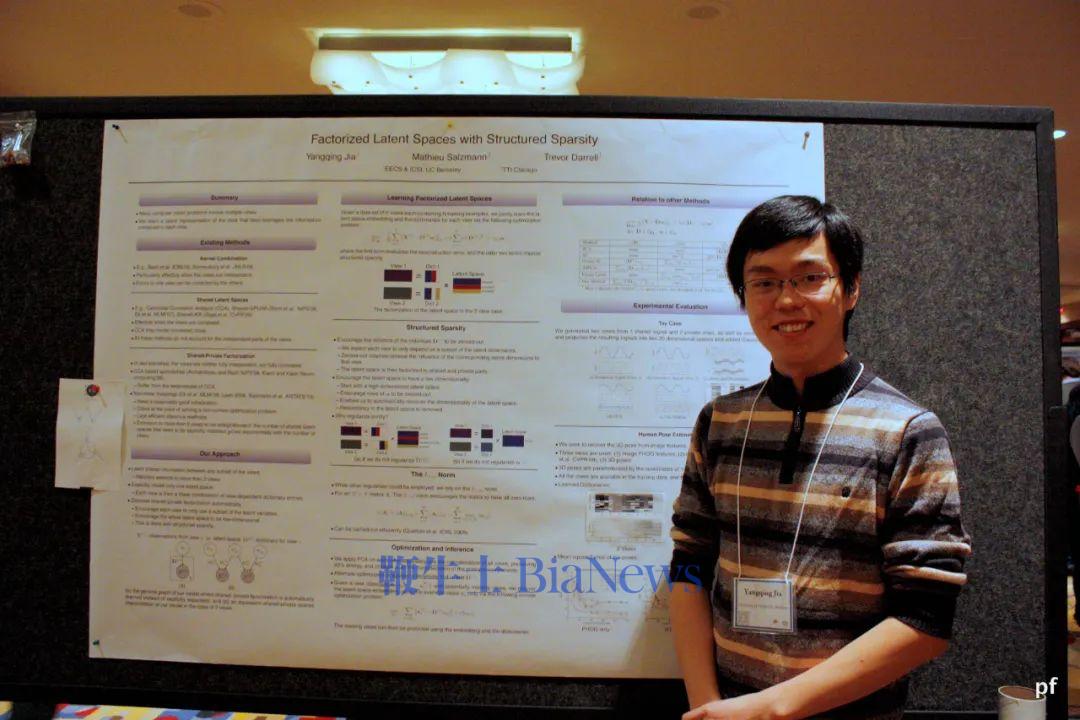

2008年,贾扬清前往加州大学伯克利分校攻读计算机科学博士,师从计算机视觉专家Trevor Darrell教授。在那里,他的研究聚焦于图像识别与表示学习,同时深入参与底层系统设计与优化工作。在博士研究过程中,贾扬清频繁与底层实现和模型部署打交道,逐渐积累起对系统构建的实践经验。他日后的职业路径也延续了这一方向:从框架设计到平台搭建,从算法落地到工具链优化。他所面对的,已经不仅是学术问题,更是如何将人工智能技术稳定、安全地推向真实应用场景的工程挑战。

第一站:搭建深度学习工程化的关键桥梁

2012 年,AlexNet (深度卷积神经网络模型) 在 ImageNet 挑战赛(ImageNet 是一个千万级图像标注数据库,而其衍生的 ImageNet 挑战赛则被誉为计算机视觉领域的“奥林匹克”,推动了深度学习模型在图像识别任务上的突破与竞赛标准。)中以碾压性优势夺冠,将卷积神经网络的潜力彻底展现,深度学习在计算机视觉领域掀起第一轮热潮,科研圈瞬间沸腾。彼时,贾扬清正攻读博士四年级,亲身经历了这场学术狂欢 —— 但他敏锐地发现了一个现实困境:前沿论文层出不穷,可支撑实验的工具却严重滞后。

当时主流的深度学习框架各有硬伤:Theano基于符号计算,代码写法晦涩,调试时连中间变量都难以查看;Torch 虽以性能和模块化设计受到部分开发者欢迎,但由于依赖 Lua 语言,生态相对小众,配置环境与实现模型相较于主流 Python 框架更为繁琐,初学者面临较高的上手门槛。哪怕只想复现一个简单模型,都得先跨过极高的工程门槛。“为什么跑通一个模型要这么难?” 作为每天泡在实验室的博士生,贾扬清深有体会 —— 很多时候,研究者的精力不是花在算法创新上,而是耗在与工具的 “搏斗” 里。

没有等待行业成熟,也没有依赖团队支持,这位普通博士生决定自己动手解决问题。2013年,他主导开发了深度学习框架Caffe,核心设计直指 “让实验落地更简单”:

用C++搭建底层框架,同时通过protobuf定义模型结构(.prototxt 配置文件),将网络层参数与代码彻底分离,研究者调整模型时无需修改核心代码,像搭积木一样直观;

深度整合CUDA与英伟达cuDNN库,配合C++的高效执行特性,让模型训练速度显著提升;

同步提供 Python和MATLAB接口,兼顾学术研究的灵活性与工业部署的实用性。

最初,Caffe只是为了满足他复现AlexNet、支持心理学实验中特征提取的需求,但开源后迅速凭借 “结构清晰、跑速快、易上手” 的特点走红:从高校实验室到微软、雅虎等企业,大量研究者用它实现了R-CNN等经典算法,甚至成为计算机视觉领域的 “入门标配”。

读博时期的贾扬清,来源:CSDN博主《新程序员》编辑部

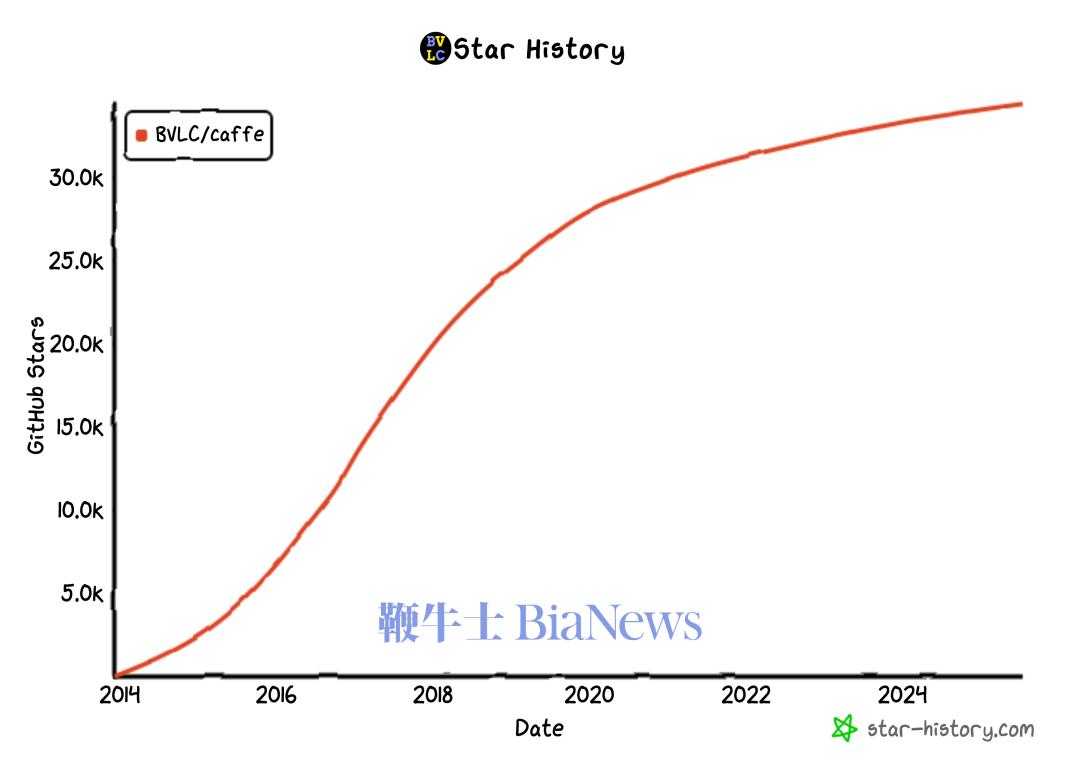

不到一年,Caffe就登上了GitHub热门榜,成为全球最受欢迎的深度学习框架之一,甚至被谷歌、Facebook、阿里、微软的多个内部项目采用。贾扬清说,“我当时根本没想着创业,就是觉得这事儿没人做,但有人总得做。”

Caffe星标增长趋势(自发布),来源:网站 GitHub Star History

那一年他 27 岁,没有融资、没有媒体宣传,只有通宵写代码的自己和愿意帮忙的几位实验室伙伴。

Caffe帮深度学习架起了从论文到工程的第一座桥,这也是他第一次站上AI工程化浪潮的浪尖。

打通孤岛:为AI模型架起“互通的USB口”

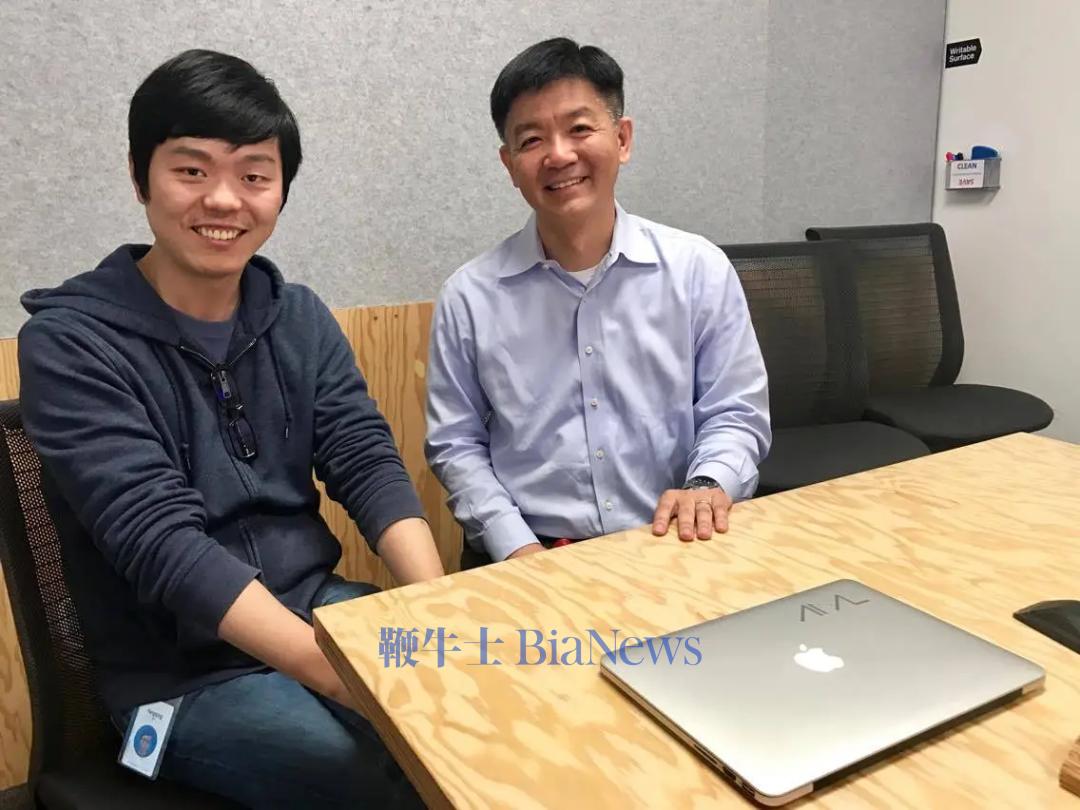

2013年贾扬清博士毕业,加入Google担任研究科学家。他原本站在Google Brain的“高地”,一边是Jeff Dean(时任Google Brain 联合创始人、Google Senior Fellow) 的深厚积累,一边是TensorFlow刚起步的全球视野,并参与构建了第一个打破人类图像分类准确性的神经网络——GoogLeNet。但他看了一圈,说:“这条路,已经很挤了。”

2016年,他调头去了Facebook,开始从底层重构一整套新的深度学习基础设施。他主导的Caffe2是第一步,比 Caffe更模块化、比TensorFlow更轻量,能部署到服务器,也能落地在移动端。

贾扬清Facebook时期工作照,来源:Facebook

可真正让他看不下去的,是生态割裂。如果你在2016年造一辆“AI高铁”,你可能要面对五种铁轨、四种电压、三种信号系统——每一家大厂都在自建闭环,每一套框架都是封闭孤岛。

训练在一个框架里,部署得用另一个框架;模型迁移得重写,运维还要配两套系统。如果用一句话形容彼时的局面,像每个国家都发明了自己的电源插头,却没人造变压器。于是他干了第二件事:推动Facebook与微软联合提出ONNX标准 —— 通过统一模型格式,实现“训练框架与部署工具的解耦”,如同“AI 界的 USB 口”。ONNX很快被PyTorch、TensorFlow等主流框架接纳,彻底改变了模型跨平台迁移的困境。

2019年,他回到中国,加入阿里云,出任智能计算平台负责人,掌管包括大数据与AI在内的底层平台业务。回国后,他并未停留在顶层设计层面,而是将大量精力投入到具体工程中,深入参与 GPU 调度、模型训练与推理系统的构建工作。此后不久,他于2019 年 9 月云栖大会首次对外发布了 飞天AI平台——一套面向商用场景打造的云端商用机器学习平台,具备统一GPU调度、训练推理协同和可视化编程能力。与此同时,他搭建的MNN推理引擎已广泛部署于手淘、天猫、优酷等 20 多个主流APP,每日调用量超过上亿次。据介绍,该平台上线后,在 GPU 调度与计算资源分配方面取得显著优化,并有效提升了大规模模型训练的整体效率。他把核心技术从构想到落地,一步步做实,真正支撑起了大模型的工程底座。

贾扬清在阿里巴巴工作时期,来源:2021阿里云峰会

这一阶段的他,开始全面接触到“企业级AI平台”的复杂性——平台不只是“技术优雅”,更要能被千人团队运维、能稳定服务于亿级请求。这种“从写得出来”到“跑得稳”的转变,是很多创业者在回国后才意识到的第一课。而他,却在这里学得很快,也很彻底。

从Facebook到阿里,从ONNX标准到飞天平台,贾扬清在不到五年内,横跨了“架构共识”和“落地执行”两个AI工程世界的两端。他不是在参与技术潮流,而是在构造潮流的轨道。

这是他第二次踏准AI工程基础设施的节拍——也是他第二次,用系统设计影响了整个行业的走向。

Lepton AI:一场从10人小队到英伟达并购的静默奇袭

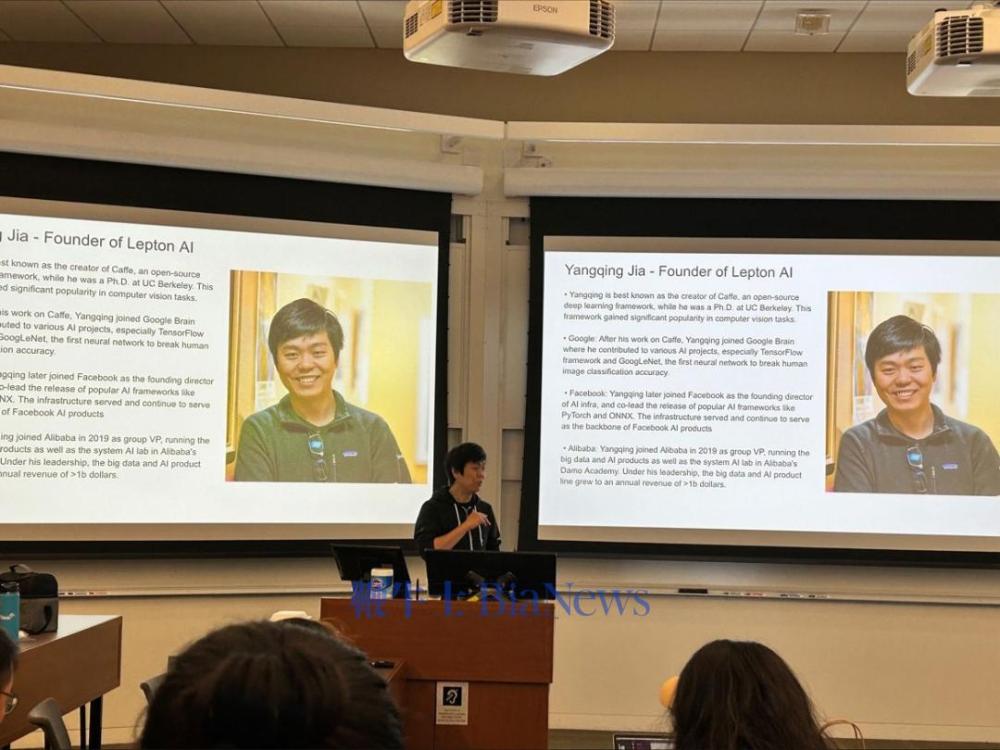

2023年,贾扬清做出又一个“反主流”的选择:他离开阿里云,在硅谷创办了自己的公司——Lepton AI。

Lepton最初只是一个GitHub主页,加上一批在工程师圈子间口口相传的demo链接。创始团队非常小,仅由少数核心工程师组成。他们没有选择去追逐大模型的热点,而是把目光投向了另一个难啃的问题:如何帮助中小团队也能稳定地部署AI模型,真正把AI“跑起来”?

Lepton的定位是“云原生推理平台”。通过容器化、多模型复用、自动调度等一系列架构优化,它让AI服务像部署网站一样简单,从而极大降低了工程化门槛。哪怕是缺乏后端和MLOps团队的初创公司,也可通过平台实现相对完整的模型推理服务部署。“很多AI公司模型训完了,却卡在部署这一步。”贾扬清曾指出,Lepton就是为了解决这个“最后一公里”的问题而生。

贾扬清代表Lepton AI团队在斯坦福大学商学院的分享,来源:LinkedIn账号 Dr Alex Szolnoki

这样的产品,注定不会立刻出圈,但对那些具备完整技术体系、深度工程能力、并关注底层架构效率的公司或团队来说,确是不可多得的“刚需解法”。

2024年底,NVIDIA注意到了Lepton的价值,向其发出收购邀约。2025年初,交易正式官宣:Lepton加入英伟达,成为其推理生态中的一环,专注于边缘AI部署和通用推理优化。虽然收购金额未公开,但据TechNode与WCCFTech多方报道,Lepton估值高达数亿美元。

这不是一次抢风口的投机收购,而是AI基础设施深耕者之间的精准拼图。

这是贾扬清第三次站上AI浪潮的高点。这一次,他用一个不到20人的团队,补齐了AI算力闭环的最后一个缺口,也将自己的系统哲学写进了全球AI芯片霸主的底层生态。

尾声:三次浪潮,一种信念

回顾贾扬清的三段“登顶时刻”,你会发现一个惊人的一致性:他并不试图“站在风口上”,而是总在默默搭建那条通向风口的铁轨。Caffe 是让深度学习第一次“跑起来”;Caffe2 和 ONNX,是让模型“互通起来”;而 Lepton,则是让部署“简单起来”。三者看似割裂,实则贯穿着同一个工程哲学:不追热点,只为落地。

在AI行业,搭建底层工具链被很多人视作低效的苦活。但贾扬清偏偏选择反其道而行,他不在意一时的技术声量,而专注于把系统的根基打牢。每一套框架、每一条协议、每一层平台,都是为了解决别人嫌麻烦的问题。他做的不是追求噱头的爆点创新,而是真正支撑行业演进的系统性创新。

这是一个时代技术架构师的画像:没有流量IP,也不是汇报演示的主角,却在技术基础层悄悄埋下能量。

AI行业仍在加速演化,模型百花齐放,芯片日新月异。但基础设施不会骗人。它见证了一个系统是否真正成立,也决定了一个技术能否真正普及。三次浪潮,贾扬清选择了三次不那么“性感”的方向,却用真实的系统逻辑和工程判断,一次次把不可能变成了现实,这份笃定,不靠算法取胜,而靠时间沉淀。(转载自Z Finance)

扫码下载app 最新资讯实时掌握

扫码下载app 最新资讯实时掌握