10月14日消息,苹果研究团队与俄亥俄州立大学联合发布论文,推出一种全新架构的语言模型——Few-Step Discrete Flow-Matching(FS-DFM)。

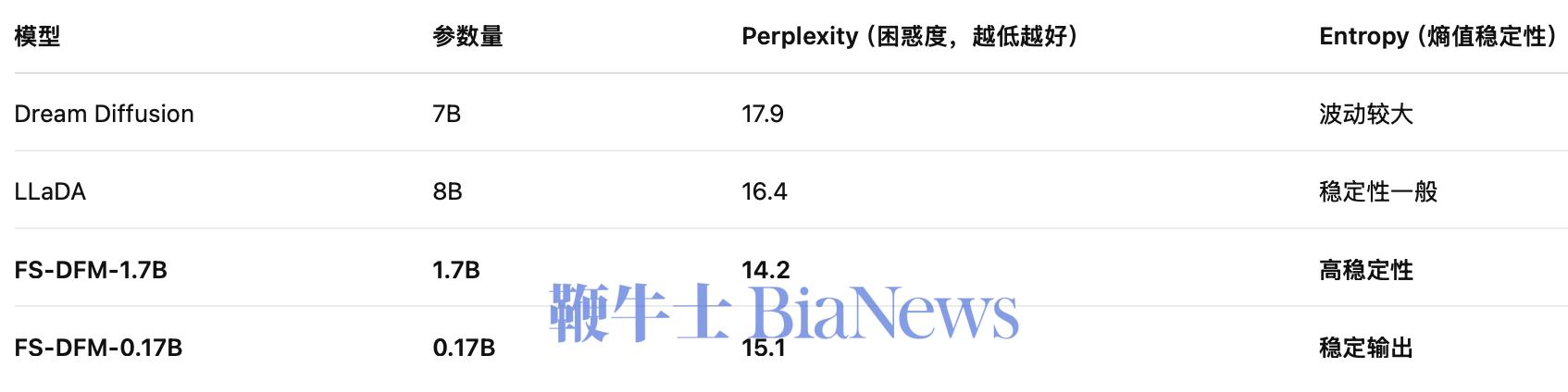

研究结果显示,该模型在生成长文本时的速度可达当前主流大语言模型的 128倍,同时在文本质量上仍保持甚至超越现有扩散类模型。

该模型采用了扩散(Diffusion)与流匹配(Flow-Matching)结合的新思路:

扩散模型可以同时生成多个token,再通过多轮迭代逐步“净化”成完整文本;

而流匹配模型进一步优化了扩散的过程,让模型几乎能“一步到位”生成高质量文本。

而当前AI语言模型(如ChatGPT、Claude、Gemini)普遍采用自回归(Autoregressive)架构,即一次只生成一个词(或token),每一步都依赖上一步的输出。

也就是说,FS-DFM不再逐字推敲,而是“整段生成—快速修正—成文输出”,只需8轮迭代,即可达到传统扩散模型需要上千步才能完成的写作效果。

在论文中指出,FS-DFM的加速秘密在于三层机制创新:

动态迭代预算(Adaptive Iteration Budget):模型能自动调整每一轮 refinement 的深度,避免无效计算。

教师指导机制(Teacher-Guided Updates):通过引入一个高精度“教师模型”,FS-DFM在每次迭代中都能更精准地更新词语,而不会“越修越乱”。

稳态收敛策略(Stable Step Optimization):优化每轮迭代的步长,让模型在更少的步骤内收敛到理想结果。

研究者指出,这意味着 FS-DFM 在“轻量模型”领域可能掀起新的革命:用更小的算力,生成更长、更自然的文本。(转自AI普瑞斯)

更多AI资讯请点击:http://www.aipress.com.cn/

扫码下载app 最新资讯实时掌握

扫码下载app 最新资讯实时掌握