最近路过北京首都机场的人,都会被一幕微妙的场景击中:阿里云、火山引擎、百度云的大幅广告并排而立,在机场偌大的空间内正面交锋。更有意思的是,它们的口号清一色都在强调“第一”或者“领先”。

再到杭州萧山机场,最抢眼的已不是登机口的航班信息,而是铺天盖地的火山引擎广告。几乎所有航站楼的通道,都被贴上了一片醒目的蓝色。阿里在杭州深耕十余年,如今却在自家门口,被字节用“AI 云”的巨幅海报狠狠盖了一层。

机场广告本该是注意力的生意,如今却成了中国云厂商混战的战鼓。谁能买下更亮的灯箱,谁就先在公众心智里贴上“AI 云第一”的标签。但在广告之外,真正的战场在机房和财报里:GPU 的价格战、调用量的冲高、资本开支的狂飙、战略分化的拉锯。

2025 年上半年,AI 把所有云厂商推上了兴奋剂般的节奏:GPU 订单暴涨、调用量冲顶、财报集体超预期。然而表象的繁荣背后,是血拼的折扣、割裂的战略。中国云计算行业正经历一次“变阵期”,而所有悬念都汇成一个问题。

谁才是中国 AI 云第一?

这个问题,得从互联网上流传最广的“两张图”说起。它们分别代表三个不同的评价维度,也恰好对应三位主角的强项。

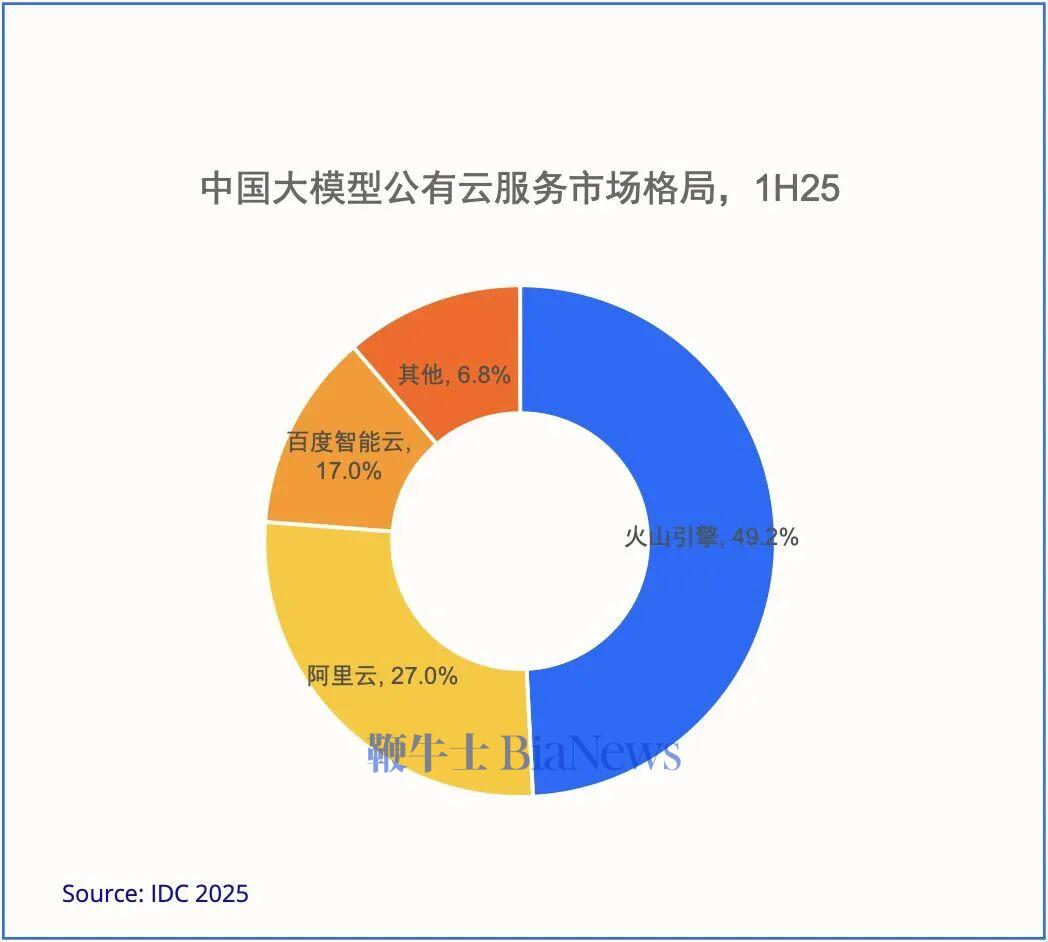

先看调用量。如果把大模型推理看作一条高速路,调用量就是上路的“车流”。IDC 报告显示,2025 年上半年中国公有云大模型调用总量约 536.7 万亿 Tokens,其中火山引擎占 49.2%,阿里云约 27%。凭借低价策略与先期资源优势,火山引擎在“流量入口”上占据领先。

图片来源:IDC

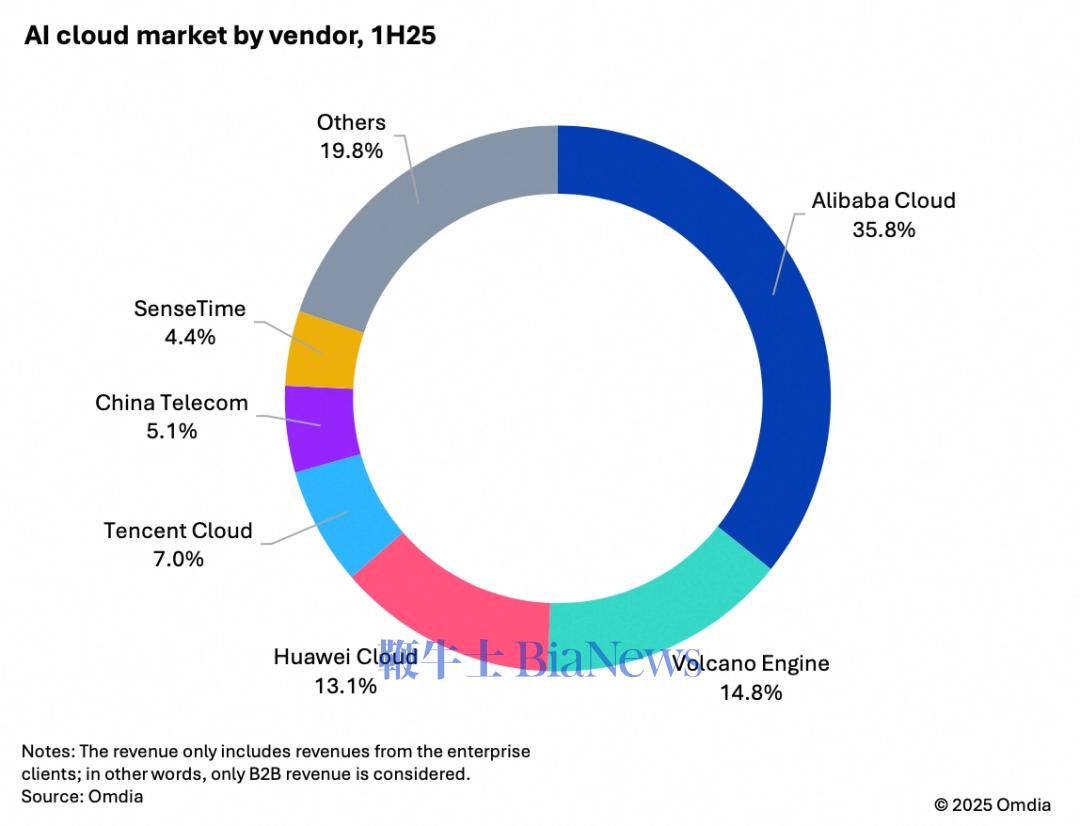

再看营收与全栈能力。这一维度关心的不是“跑了多少趟”,而是“整车赚了多少钱、车队有多大”。Omdia 给出的结论是:阿里云在中国 AI 云市场(仅考虑企业客户)份额 35.8%,超过第 2 至第 4 名之和;加之未来三年 3800 亿元 的云与 AI 基建投入,阿里云是在资本规模与全栈能力上最接近国际一线(AWS、微软、谷歌)的国内厂商。

图片来源:Omdia

为什么同一条赛道,会得出不同的第一?

最关键的差别在于口径。调用量可以理解为“流量口径”,主要衡量推理 API 的使用频次和吞吐能力,受 Token 单价、免费额度、促销策略和模型压缩效率等因素影响;而市场份额则是“营收口径”,计算的是 IaaS、PaaS 与 MaaS 的整体收入,以及长期合约和项目交付。

从优点来看,调用量口径直观、灵敏,能够反映模型的活跃度和生态热度。但公有云调用量的局限在于,它无法覆盖私有化和“一体机”部署。阿里云在云栖大会上就曾回应,许多客户会选择在阿里云或自建基础设施上直接部署通义千问、通义万相,这部分并未纳入 API 调用统计,因此真实使用规模往往高于公开数据所呈现的水平。

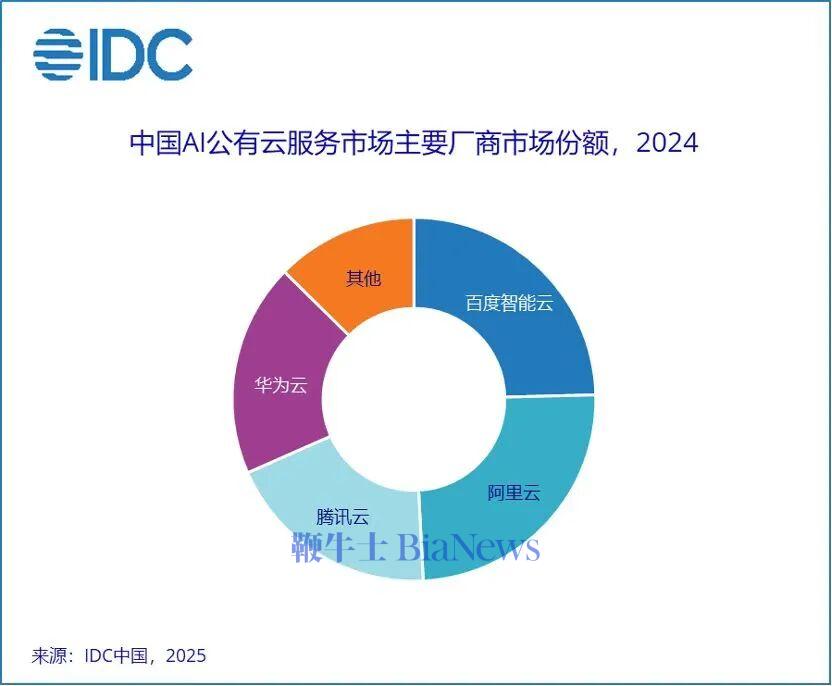

相比之下,营收口径也并非万能。传统 IaaS 收入口径更侧重计算、存储和网络等通用资源,其规模容易受到价格战和资源扩张的拉动,从而放大算力和带宽层面的竞争,却难以准确衡量厂商在 AI 技术与应用上的实力。IDC 在另一份报告在统计市场份额时,用计算机视觉、对话式 AI、智能语音、自然语言处理和机器学习平台等与 AI 直接相关的领域作为观察窗口,提供了一个新的独特视角。

图片来源:IDC

不同厂商采用不同的口径,背后其实是产品结构、客户结构的不同。

产品结构上,火山引擎更偏 MaaS 推理 + 轻交付,主打法是低门槛、即插即用与极致性价比,叠加先期囤的推理卡,最适合迅速把调用量做“爆”;但这种结构对营收/毛利的贡献更像“薄片”,量起得快、客单不一定厚。阿里云是典型的全栈大拼盘,靠一体化方案绑定大客户,客单厚、续费长、周边服务多,营收份额自然占优。百度走的是工程重、行业深的路线,把文心体系嵌进政务/金融/交通/教育等垂直场景,单体项目金额大、门槛高,但短期未必形成“好看”的公有云调用曲线。

客户结构上, 火山的主力是开发者、中小企业与互联网应用方,“高频低价、拉新快、流失也快”,调用曲线最容易被拉高;阿里云更集中于大型企业与跨行业集团,采购的是“算力 + 数据 + 平台 + 服务”的整套,常见多年期合同,ARPU 与续费率把营收曲线压得稳。

总结来说,火山引擎拿的是入口与流量的第一,阿里云坐的是营收与全栈的第一,百度守的是工程与深度的第一。真正意义上的“AI 云第一”,要看未来三到五年谁能把三条曲线叠到同一个拐点:调用规模继续放大、资本底座持续加厚、行业粘性不断上升。当这三件事同时成立,“唯一的第一”才会出现。

下半场:AI 云的未来战局

上半年的混战已经表明,真正的比拼不再是单点算力或单个模型,而是“算力—模型—应用”能否被焊死在一起,形成全链路闭环。未来三到五年的胜负,不再取决于短期的增长爆表,而是谁能把云从“加一点 AI”真正升级为“新一代电力系统”。掌握发电(算力供给)、输电(模型与平台)、负载(应用与生态)的整体能力,才算站稳赛道。

接下来,有几个方向决定战局。

资本阈值持续抬高:比的不是“谁花得多”,而是“谁花得值”

阿里提出三年 3800 亿元 AI 基建,信号不在金额本身,而在资产结构与折旧周期:自有/租赁数据中心、专用电力与网络、定制化加速器与冷却系统,会把云厂的资产负债表“重化”。短期利润承压几乎是必然,但只要“资本→可用算力”的转化效率高,重资产会反而形成长期壁垒。真正的比较单位不应是“亿元”,而是每亿元能换来多少“可调度 TFLOPS/月”、PUE/WUE 能耗指标能做到多低、上架到可售 SKU 的周转时间有多短,以及这些算力能否被高毛利产品(数据库、数据智能、企业安全与行业解决方案)长期“挂靠”。

更深一层的变数在供给链与能源:高端 GPU 供给不确定、绿电配额与电价波动、机房选址的水资源与排热条件,都会改变同一笔 CAPEX 的“含金量”。因此判断一家厂商资本优势是否可持续,至少看四个比值:CAPEX→上架算力的月转化率、单位算力的全生命周期成本(含电力/维护/折旧)、高毛利产品对算力收入的“带挂率”、以及合同期内的负载率(避免“闲置算力”成为沉没成本)。做不到这四点,“大投”很容易变成“大负担”。

推理入口之争:Token 是“虚火”,留存与提价权才是“真火”

2025 年上半年公有云调用量被测到约 536.7 万亿 Tokens,这个“门面”决定了谁更被开发者看见,但它天然偏向价格与促销。入口的真正价值取决于三件事:一是能否把短频快的 API 调用升级为有状态的工作流(检索、工具调用、多人协作、长时记忆),从“瞬时流量”变成“持续水位”;二是能否把公有云端点延伸到私有化/专有域与本地一体机,让企业数据与治理框架长期驻留;三是能否在新交互形态(语音/视频流、Agent 级自动化、端云协同)中拿到低时延与高稳定的体验优势。这三件事决定了入口能否转化为更高 ARPU 与更低流失”。

全栈自研 vs 平台聚合:一边是“性能/成本/控制权”,一边是“速度/广度/弹性”

平台聚合(如 Azure 的多模型接入)带来的是“快”与“广”:生态丰富、上新迅速、产品线不必处处自研;代价是对上游模型供应的依赖加深,议价权、成本与路线可预期性会波动。全栈自研(典型如谷歌的 TPU+模型协同、国内的芯片/算力/模型/平台耦合)强调的是“深”:通过软硬协同把性能/时延/单位成本压到行业极限,并把关键路径牢牢掌控在内;代价是组织复杂度、研发门槛与 CAPEX 压力的急剧上升。

未来更可能出现“折中最优”:关键路径自研 + 非关键路径合作。也就是在推理调度、编译优化、缓存体系、隐私计算、数据治理等“性能与合规决定成败”的环节坚持自研;而在通用模型供给上保持开放路由与多模型编排,既保证体验,又避免单一供应依赖。评估这两种路线优劣,不妨盯三个可验指标:同等质量下的单位推理成本/千 Tokens、跨模型路由的成功率与总时延、以及自研链路的版本演进速度(能否季度级别持续降本提效)。谁能把这三个数同时做优,且不牺牲生态广度,谁就能把“技术优势”兑换成“业务抗周期”。

一个更偏执但现实的判断是:未来三到五年,中国 AI 云格局不会“胜者通吃”,但胜者通道一定极窄。要跨过的门槛有四道:持续千亿级资本投入并能转化为算力,百万级集群与云操作系统的调度能力,顶级大模型与多模型的工程化效率,以及芯片与上游供给的可控性。谁能在这四道门槛上全部过关,谁才有资格成为 AI 时代真正的“电力公司”。(转载自Z Finance)

扫码下载app 最新资讯实时掌握

扫码下载app 最新资讯实时掌握